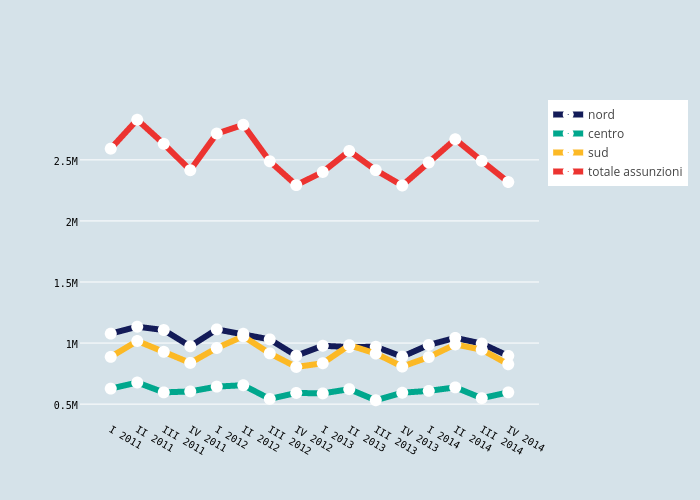

La settimana scorsa si è tenuto l’annuale raduno della comunità italiana dei dati aperti: Spaghetti Open Data.

Insieme ad altri ho lavorato sui dati (aperti) su lavoro.

Tra le altre cose ne è scaturito un articolo, che ho pubblicato su Medium.

https://medium.com/italia/i-dati-sul-lavoro-vogliono-essere-liberati-858829f429ce

Tuesday, 7 April 2015

Monday, 19 January 2015

Better Open Data 2: Identifiers

Siamo all’alba dell’era del riuso dei dati.

Dopo aver parlato tempo fa di RDF, termini e schema standard, oggi vorrei parlare di identificatori.

L'input è arrivato da questo white paper, ben scritto da ODI e Thomson Reuters.

Rimando direttamente al documento per un approfondimento mentre provo a definire qui un'azione che dovremmo adottare fin da subito per aumentare le possibiltà di riuso dei dati (come? ne parliamo a #sod15 !? ).

L'azione è semplice:

(Ri)Usare identificatori Persistenti per le Risorse più importanti

Esempio:

In un csv che descrive i soldi spesi dai comuni usare, a fianco del nome del comune, inserire anche l'ID/URL di DBPedia e/o altri dataset presi come riferimento.

Perchè farlo?

* Perchè in questo modo è enormemente più semplice incrociare dataset diversi

* Perchè solo utilizzando più dataset e fonti di dati si possono costruire applicazioni con un alto valore

* Perchè in questo modo si internazionalizza il dato

Come si realizza?

A) Per una nuova applicazione che nasce ora e che (quindi) deve supportare pubblicazioni in open data, adottare internemante identificatori persistenti.

B) Per migliorare un dataset esistente si deve:

* Identificare lo standard di identificazione più adeguato per il tipo di risorse che dobbiamo descrivere

* Riconciliare le entità agli identificatori attraverso procedure semi-automatiche utilizzando strumenti esistenti come Openrefine.

E se non esiste API di riconciliazione per il nostro caso?

In questo caso lo si deve costruire, e lo può/deve fare per primo chi pubblica questi dati autoritari e per secondo la community.

Dopo aver parlato tempo fa di RDF, termini e schema standard, oggi vorrei parlare di identificatori.

L'input è arrivato da questo white paper, ben scritto da ODI e Thomson Reuters.

Rimando direttamente al documento per un approfondimento mentre provo a definire qui un'azione che dovremmo adottare fin da subito per aumentare le possibiltà di riuso dei dati (come? ne parliamo a #sod15 !? ).

L'azione è semplice:

(Ri)Usare identificatori Persistenti per le Risorse più importanti

Esempio:

In un csv che descrive i soldi spesi dai comuni usare, a fianco del nome del comune, inserire anche l'ID/URL di DBPedia e/o altri dataset presi come riferimento.

Perchè farlo?

* Perchè in questo modo è enormemente più semplice incrociare dataset diversi

* Perchè solo utilizzando più dataset e fonti di dati si possono costruire applicazioni con un alto valore

* Perchè in questo modo si internazionalizza il dato

Come si realizza?

A) Per una nuova applicazione che nasce ora e che (quindi) deve supportare pubblicazioni in open data, adottare internemante identificatori persistenti.

B) Per migliorare un dataset esistente si deve:

* Identificare lo standard di identificazione più adeguato per il tipo di risorse che dobbiamo descrivere

* Riconciliare le entità agli identificatori attraverso procedure semi-automatiche utilizzando strumenti esistenti come Openrefine.

E se non esiste API di riconciliazione per il nostro caso?

In questo caso lo si deve costruire, e lo può/deve fare per primo chi pubblica questi dati autoritari e per secondo la community.

Wednesday, 15 October 2014

Piove, governo ladro!

L'Idea nasce durante #hackToscana e punta ad attuare la gestione partecipata dell'informazione legata al rischio e alle emergenze.

Ecco la pagina di presentazione:

http://hacktoscana.github.io/pioveGovernoLadro/

All'hackathon abbiamo presentato l'idea cercando di mettere in luce:

Per prima cosa stiamo scrivendo:

Diverse persone inoltre stanno discutendo sul tema dell'uso della tecnologia per prevenire e gestire le emergenze:

Ecco la pagina di presentazione:

http://hacktoscana.github.io/pioveGovernoLadro/

All'hackathon abbiamo presentato l'idea cercando di mettere in luce:

- la fattibilità

- le differenze e i punti di contatto rispetto a esperienze e strumenti esistenti

- l'innovazione nella gestione delle informazioni partecipata cittadini-esperti-amministrazioni

- la proposta di un sistema di controllo della qualità delle informazioni

Per prima cosa stiamo scrivendo:

- Una grammatica di hashtag per informazioni su rischi ed emergenze https://docs.google.com/document/d/14VqjSFGQ3dFjnsU_efKostQWbPjFkqLtlc-2XPyS0P0/edit?usp=sharing

- Una lista di account di istituzioni ed "esperti" relativi alle emergenze e al rischio ambientale

https://docs.google.com/spreadsheets/d/1aPIvVRrqF5PkHClpOqTzOwsBkx8Mp7l2zk2fOJjK7HE/edit?usp=sharing

Diverse persone inoltre stanno discutendo sul tema dell'uso della tecnologia per prevenire e gestire le emergenze:

- Sul gruppo Speghetti Open Data:

https://groups.google.com/forum/?fromgroups=#!topic/spaghettiopendata/lWQuW4HkO70 - Sul gruupo Facebook #emergenzeHack:

https://www.facebook.com/groups/833728609982766/

Thursday, 9 October 2014

La mia storia per digitalchampions.it

Mi definisco un civic hacker con la passione per l'educazione.

Mi emoziono ad insegnare ai bambini a programmare il loro gioco nei coderdojo, nell'inventare software utili per la scuola di domani e nel promuovere un nuovo modo di imparare grazie al superamento del libro cartaceo.

Mi diverto quando partecipando ai raduni di spaghetti open data creiamo consapevolezza nei cittadini graficando le storie che i dati vogliono raccontare oppure quando ho l'opportunità di dare il mio contributo per rendere una regione più innovativa (sabato si va ad hacktoscana!).

Uno dei temi che più mi appassiona è la partecipazione civica alla vita delle comubnità e il nuovo modo di fare politica che prende il nome di open government.

In questo ambito ho un sogno nel cassetto: trovare il modo di dare un riconoscimento alle persone e le comunità che dedicano impegno ai beni comuni, che fanno monitoraggio civico, che partecipano.

Persone con idee innovative che vogliono risolvere problemi reali e sentiti, persone che lo stato deve ascoltare e valorizzare per arrivare a promuovere un modo nuovo di essere italiani, europei e cittadini del mondo.

Mi emoziono ad insegnare ai bambini a programmare il loro gioco nei coderdojo, nell'inventare software utili per la scuola di domani e nel promuovere un nuovo modo di imparare grazie al superamento del libro cartaceo.

Mi diverto quando partecipando ai raduni di spaghetti open data creiamo consapevolezza nei cittadini graficando le storie che i dati vogliono raccontare oppure quando ho l'opportunità di dare il mio contributo per rendere una regione più innovativa (sabato si va ad hacktoscana!).

Uno dei temi che più mi appassiona è la partecipazione civica alla vita delle comubnità e il nuovo modo di fare politica che prende il nome di open government.

In questo ambito ho un sogno nel cassetto: trovare il modo di dare un riconoscimento alle persone e le comunità che dedicano impegno ai beni comuni, che fanno monitoraggio civico, che partecipano.

Persone con idee innovative che vogliono risolvere problemi reali e sentiti, persone che lo stato deve ascoltare e valorizzare per arrivare a promuovere un modo nuovo di essere italiani, europei e cittadini del mondo.

Friday, 5 September 2014

When and why use RDF (from RES project by BBC, Jisc and BUFVC)

From the technical documentation of this very interesting project you can find here :

Why does RES use RDF?

RDF isn’t necessarily the simplest way of expressing some data

about something, and that means it’s often not the first choice for

publishers and consumers. Often, an application consuming some

data is designed specifically for one particular dataset, and so its

interactions are essentially bespoke and comparatively easy to

define.

RES, by nature, brings together a large number of different structured

datasets, describing lots of different kinds of things, with a need for a

wide range of applications to be able to work with those sets in a

consistent fashion.

At the time of writing (ten years after its introduction), RDF’s use of

URIs as identifiers, common vocabularies and data types, inherent

flexibility and well-defined structure means that is the only option for

achieving this.

Thanks for this, I will use it in my Linked Data speech! :)

Tuesday, 22 July 2014

Dettare l’agenda: come la comunità open data è entrata nel radar delle politiche europee

Non scrivo mai post "proxy", ma questa volta faccio un'eccezione per raccontarvi un'aneddotto che mi inorgoglisce un po.

Per prima cosa leggetivi l'articolo dello spaghettaro Alberto Cottica:

http://www.cottica.net/2014/07/22/dettare-lagenda-come-la-comunita-open-data-e-entrata-nel-radar-delle-politiche-europee/

Vorrei aggiugnere un punto 0 gogliardico alle puntate precedenti:

Raduno Spaghetti Open Data, cena del Venerdi 28 Marzo.

Dopo aver fatto i caciaroni alla Cantina Bentivoglio manco fossimo una gita delle medie stiamo in giro per bologna a bere e chiacchierare.

Ad un certo punto sono con Alberto Cottica e Matteo Brunati e si ragiona sul fatto che non ci siano esponenti del progetto ePSI tranne Matteo, italiano, già super conosciuto tra noi spaghettari.

Questa è la politica del progetto sulla partecipazione agli eventi ci spiega. Forse per motivi economici penso io, comunque sbagliata.

Alberto non ci sta, è abituato a "fare rete" in Europa, e subito partiamo con il capire cosa darebbe uno scambio culturale a tema Open Data.

Pensiamo a quanto potrebbe essere utile far venire un ragazzino che ne so, portoghese, a capire che facciamo qui in Italia, a quanto potrebbe diffondere idee in giro per l'Europa.

Un viaggio pagato? Una borsa di studio?

Ecco che Alberto la spara: ci vorrebbe un Erasmus degli Open Data.

Sorrido, penso "magari".. :)

Thursday, 13 March 2014

My Cinema Knowledge: "my movies 2" aka kiss open refine

In this episode of " My Cinema Knowledge" I will try to link video files I have on my pc with Freebase. I tried to keep the process as simple as possible and this time the requiremt is only a normal laptop with open refine and its extensions.

Use of this data in the next post!

In order to make a uri out of row index I just used a custom vale: "http://www.mycinemaknowledge/video/" + value

Use of this data in the next post!

Step By Step How-to

- Build a csv with all the film names. I used folders names in my disk extracted using a linux command ( find . -type d > myMovies.csv )

- Import in open refine (I used ver2.6)

- Extracted movie name from folder name taking only the last part of the location. For me it was something like this in GREL:

value.split("/")[value.split("/").length()-1]

Here a guide:

https://github.com/OpenRefine/OpenRefine/wiki/Understanding-Expressions

- Reconciliation: There is now a cloud based reconciliation service for freebase, now working also with italian language. It should be included in open refine but it does not work for this bug https://github.com/OpenRefine/OpenRefine/issues/805. You can make it work creating a new standard one using this address: http://reconcile.freebaseapps.com/reconcile

- Run reconciliation selecting the "film" type

- Select the match with a "high" match using the facet on best match score

- match all cell to the highest candidate (from reconciliation->action)

- Manually find a match for other items

- Add new column based on the reconciliated one with expression: cell.recon.match.id

- In order to have the freebase rdf id add new column based on the last one with expression: "http://rdf.freebase.com/ns/" + "m." +

value.split("/")[value.split("/").length()-1]

- Download and compile rdf-extension: https://github.com/fadmaa/grefine-rdf-extension

- Edit rdf skeleton like this: (preview does not work because of https://github.com/fadmaa/grefine-rdf-extension/issues/89)

In order to make a uri out of row index I just used a custom vale: "http://www.mycinemaknowledge/video/" + value

- Export in rdf

Subscribe to:

Comments

(

Atom

)